Erfahren Sie mehr zu Confidential AI bei der Open Confidential Computing Conference am 12. März!

Mit Privatemode können Sie moderne cloudbasierte KI in Ihre n8n-Workflows einbinden – bei vollständiger Kontrolle über Ihre Daten.

Viele Nutzer betreiben n8n lokal, um die Kontrolle über ihre Daten zu behalten. Dabei stehen sie jedoch vor dem Dilemma, entweder auf lokale KI-Modelle mit eingeschränkten Fähigkeiten zu setzen oder auf cloudbasierte KI zurückzugreifen – mit möglichen Datenschutzrisiken. Mit Privatemode entfällt dieser Kompromiss: Durch Confidential Computing können Sie cloudbasierte KI nutzen, ohne Ihre Daten aus der Hand zu geben. Die Daten bleiben durchgängig geschützt – auch während der Verarbeitung.

Die Integration von Privatemode in n8n ermöglicht den Einsatz vertraulicher KI-Modelle in Ihren Workflows – mit Ende-zu-Ende-Verschlüsselung und Confidential Computing. Privatemode ist so konzipiert, dass es Ihre Daten nie speichert oder auswertet.

Mit Privatemode können Sie moderne LLMs auswählen und einsetzen – direkt in Ihren n8n-Workflows.

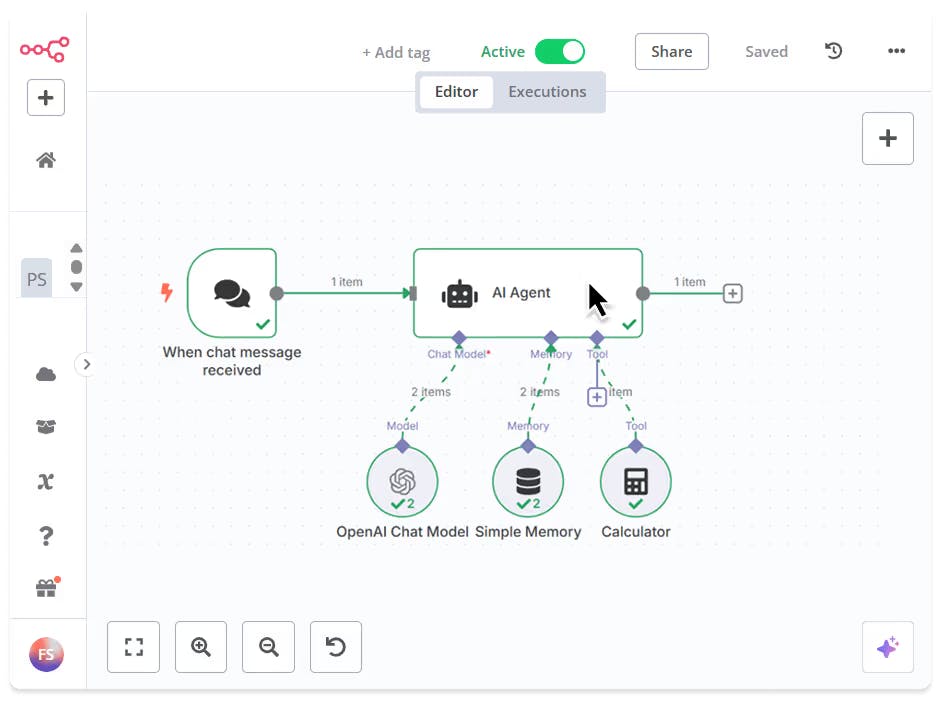

Privatemode lässt sich in wenigen Minuten in n8n integrieren. Der Aufbau ist unkompliziert und kompatibel mit nativen KI-Nodes in n8n.

Falls Sie noch keinen Privatemode API-Schlüssel haben, können Sie ihn hier kostenlos anfordern.

Der Proxy überprüft die Integrität des Privatemode-Dienstes mithilfe von Confidential Computing–basierter Remote Attestation. Zudem verschlüsselt er alle Daten vor dem Versand und entschlüsselt sie erst nach Erhalt der Antwort.

Folgen Sie dem offiziellen n8n-Tutorial zur Einrichtung eines AI-Agenten. Da Privatemode AI der OpenAI-Interface-Spezifikation entspricht, kann der Standard-OpenAI-Chat-Node wie im Tutorial beschrieben verwendet werden. Die Zugangsdaten müssen jedoch gemäß Schritt 5 des Tutorials angepasst werden.Zusätzlich zum AI-Agenten-Node kann das OpenAI-Chat-Modell auch in mehreren weiteren leistungsfähigen AI-Nodes verwendet werden, darunter:

Passen Sie die Zugangsdaten für den OpenAI Chat Model-Node an. So wird sichergestellt, dass keine Daten an OpenAI gesendet werden, sondern ausschließlich an Ihren Privatemode-Proxy. Dieser stellt einen Ende-zu-Ende-verschlüsselten Kanal zu unserem Confidential-AI-Dienst her.

Legen Sie die Parameter der OpenAI Chat Model-Nodes fest, um die korrekten Zugangsdaten zu verwenden und das gewünschte Modell auszuwählen:

Sie haben Confidential AI erfolgreich in Ihren Workflow integriert.

© 2026 Edgeless Systems GmbH